计算资源设计

基于Nutanix架构的模块化数据中心由Nutanix Block (区块)和Nutanix Node (节点)组成。下图为标准的一个Block (区块)设备,仅占用2个机架单元 (2U高)。而每台标准的Nutanix Block (区块) 设备均含有四个独立的Nutanix节点,每个Node(节点)都是一台独立的x86服务器。却能够提供4台标准2路Intel CPU的x86 服务器。

Nutanix Block (区块 ) 和 Node (节点 )

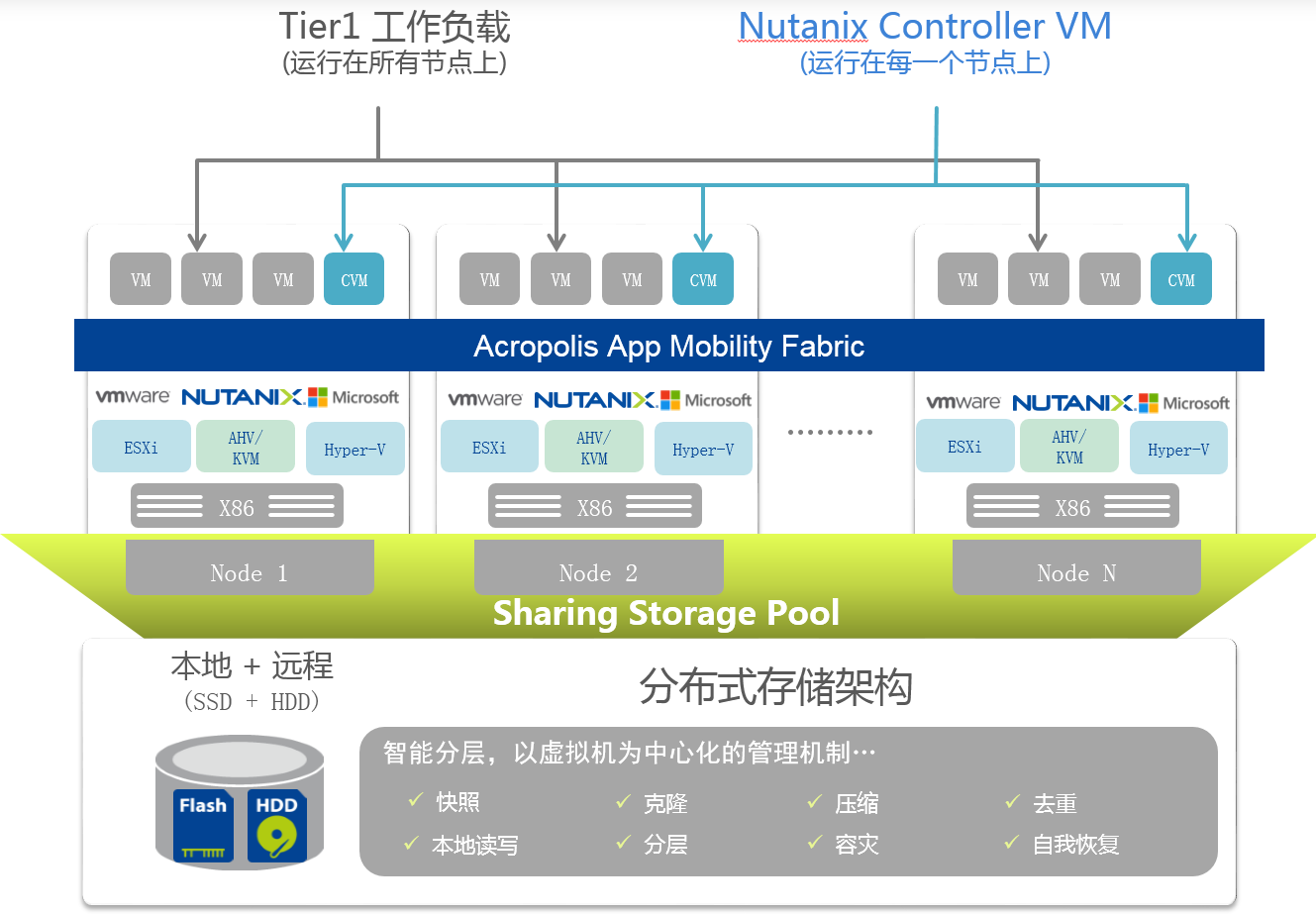

Nutanix的计算资源池是通过x86服务器虚拟化来实现的,可以支持VMware vSphere、MicroSoft Hyper-v及Nutanix Acropolis平台提供的KVM等Hypervisor。

在虚拟化Hypervisor层形成计算资源池,为业务系统的虚拟机提供不同的服务质量和能力,包括了高可用(High Availability)、容错(Fault Tolerant)、在线迁移(Live Migration/vMotion)、资源动态负载均衡(Distributed Resource Scheduler)等虚拟化的特性。

同时,Nutanix可以支持业务虚拟机在不同的Hypervisor之前进行迁移,也就是V2V的能力,例如从vSphere迁移到KVM等。

超融合架构计算资源池(x86服务器虚拟化)

存储资源

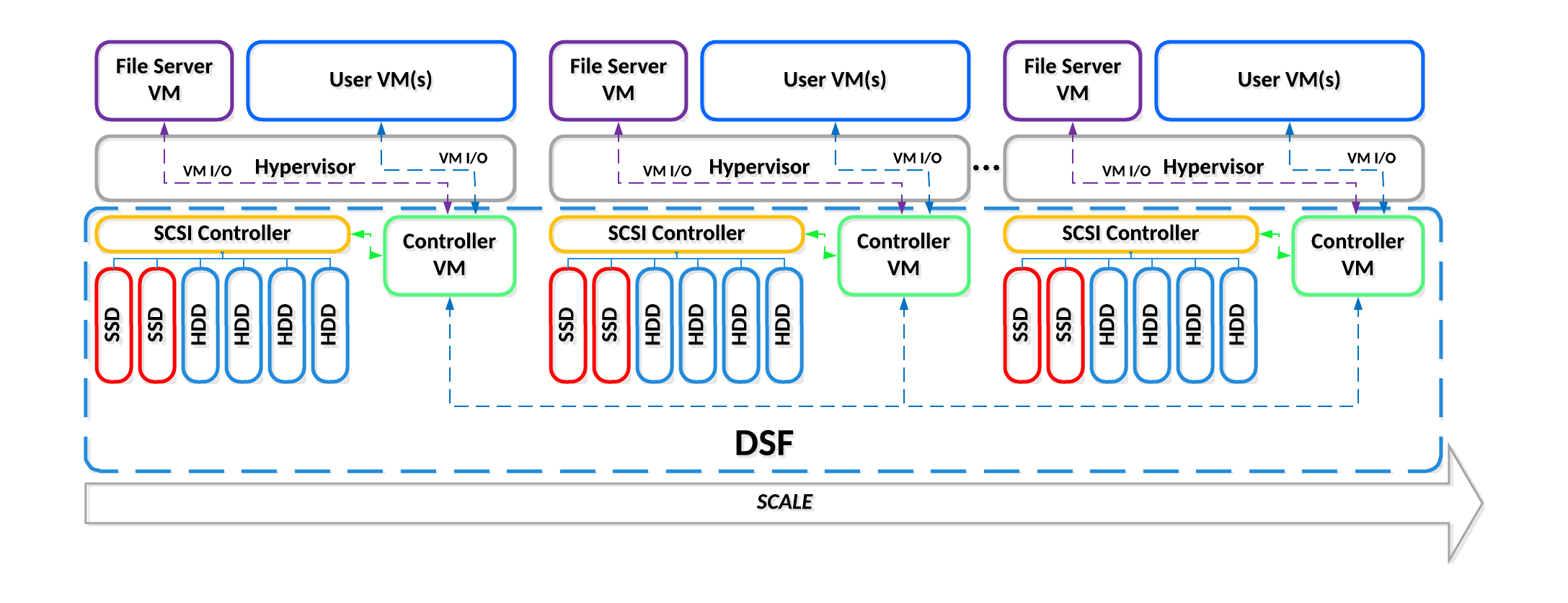

Nutanix提供的分布式文件系统(NDFS)可以将一组集群内的节点组成一个统一的分布式存储平台。NDFS对于x86虚拟化平台软件而言就是一个集中的共享式存储,与任何其他集中式存储阵列一样工作,且提供更为简单便捷的存储管理,无需像传统集中存储那样再配置LUN、卷、或者Raid组。

Nutanix分布式存储架构和功能

Nutanix分布式存储架构不仅同样提供传统存储的能力外,还提供更多的能力。针对于虚拟化方面提供快照、克隆等机制,数据层实现本地优先访问、存储分层等性能机制,对数据进行压缩和去重提高存储可用容量,借助两份以上冗余数据提供存储的可靠性,增加或减少节点数据分布会自动平台,当节点宕机或磁盘损坏后具备数据自恢复能力等。

Nutanix每个节点提供两种磁盘,标准配置为1-2块SSD,容量从960GB到3.84TB;4块SATA的HDD,容量为2TB~12TB 。

分布式存储系统逻辑架构

NDFS被设计成为非常动态的平台,可以适用于不同工作负载的应用,并且允许混合节点类型:例如将计算密集型节点和存储密集型节点混合在一个集群中。对于集群内部磁盘容量大小不同的,确保数据一致的分布非常重要。NDFS有自带的称为磁盘平衡的技术,用来确保数据一致的分布在集群内部各节点上。磁盘平衡功能与各节点的本地磁盘利用率和内置的NDFS ILM(数据生命周期管理)一同工作。它的目标是使得所有节点的磁盘利用率大致相等。

另外,Nutanix节点通过ILM实现SSD和HDD的数据热分层。简单而言,磁盘的热分层时实现在集群内所有节点的SSD和HDD上,并且由ILM负责触发数据在热分层之间的迁移。本地节点的SSD在热分层中是最高优先级的,负责所有本地虚拟机IO的读写操作。并且还可以使用集群内所有其他节点的SSD,因为SSD层总是能提供最好的读写性能,并且在混合存储环境中尤为重要。

在超融合的虚拟化环境中,所有IO操作都将由本地节点上的Nutanix Controler VM(CVM)接管,以提供极高的性能。据以往经验及用户习惯分析,一般运行服务器虚拟化的虚拟机对IO性能要求在200-300 IOPS左右,而单个Nutanix节点可提供25000上的IOPS,4节点集群可提供将近100,000的IOPS。完全可以满足需求。

网络拓扑

在每个单节点上,默认提供如下网络端口:

标配 | 2x 1 GbE, 1x 1 GbE RJ45 (IPMI) |

附加 | Dual-Port 10 GbE/Quad-Port 10 GbE/Dual-Port 10 GBASE-T2x 1 GbE, 1x 1GbE RJ45 (IPMI) |

下图为Nutanix推荐的网络拓扑图:

网络拓扑

在计算虚拟化资源池中的每台虚拟化Hypervisor节点上会运行多台虚拟机,多台虚拟机之间共享网络,为了方便管理建议采用虚拟交换机来配置和管理网络,虚拟交换机可在数据中心级别提供集中和聚合的虚拟网络,从而简化并增强虚拟机网络。在虚拟交换机的网络划分上,仍然可以采用VLAN的方式划分不同的子网,实现不同子网段的安全和隔离。

在网络隔离上,也可以采用网络虚拟化VXLAN技术。VXLAN网络协议,即VLAN协议的扩展版本。VXLAN网络可以跨越物理边界,从而跨不连续的数据中心和集群来优化计算资源利用率。VXLAN采用逻辑网络与物理拓扑相互分离,使用IP的技术,所以无需重新配置底层物理网络设备即可扩展VXLAN网络。正因如此,也就无需再花费大量时间来规划如何调配VLAN及管理VLAN数量剧增问题。

在每个Nutanix物理节点上有多种网络需求,包括管内部通讯网络、管理网络、生产网络等,因此每个Nutanix节点需配置多块网卡,网络设计建议如下:

类型 | 设计 | 备注 |

Nutanix物理节点之间的内部通讯网络 | 10Gb以太网 双链路冗余 | 每个节点通过两条万兆链路分别连接两台万兆交换机,保证网络设备和链路的冗余度。 Nutanix建议用户使用万兆网络互联物理节点,当发生密集的写IO时,万兆网络能保证提供足够带宽满足节点之间的IO同步流量。 |

客户端与服务器虚拟机之间的通讯网络,虚拟化服务器对外服务网络 | 1Gb/10Gb以太网,双链路冗余 | 每个节点通过两条千/万兆链路分别连接两台千/万兆交换机,保证网络设备和链路的冗余度。 用户访问虚拟服务器对外提供服务时,通过千/万兆链路可以实现与后端存储流量隔离。 |

硬件管理网络 (IPMI) | 1Gb以太网 | 每个节点都有独立的千兆链路,用于连接专门的管理网络,实现管理网络与业务网络、存储网络分离。可以最大限度保证管理的灵活性和安全性。 |

备份容灾

Nutanix平台自带的存储层面及基于虚拟机粒度的备份恢复功能Time Stream。用户可以针对每个虚拟机设置不同的备份策略,包括备份计划和备份保留周期,Time Stream会自动通过存储快照方式对虚拟机进行备份。所有Time Stream的快照均是基于存储层面的,与虚拟化层面(例如VMware vSphere)的快照不同,存储层面的快照不会影响虚拟机的性能,对于虚拟化软件是完全透明的。

传统的备份方式通过网络传输备份数据,需要特定的备份窗口以免影响业务正常运行。Time Stream备份可以与传统的备份策略互补,既能保证对于重要的虚拟机进行高频度备份又不会占用额外的网络带宽。例如:

·对于普通虚拟机可以使用传统的备份方式每周进行全备,将备份数据保留在外部存储(例如磁带库中);同时使用Time Stream备份进行每天甚至每12小时的备份,数据直接保留在存储上以便快速恢复。

· 对于比较重要的虚拟机可以使用传统备份每周全备、每天增量的方式,将备份数据保留在外部存储(例如磁带库中);同时使用Time Stream备份进行每2小时甚至每小时的备份,数据直接保留在存储上以便快速恢复。

·可以采用vSphere Data Protection Advanced(简称VDPA,只针对vSphere)、Commvault(VMware和Hyper-v)、Weeam(vSphere和Hyper-v)等虚拟化备份解决方案作为有效补充。

Nutanix容灾功能,分为两个级别:Metro Availability和Remote Replication。都是基于虚拟机快照的方式将更新数据异步复制到远程的Nutnaix集群中。Metro Availability可以实现同城双数据中心之间的RPO接近于“零”(需要裸光纤支持),即便是标准Remote Replication也能实现RPO为1小时(基于网络带宽和更新数据量),满足绝大多数异地容灾的业务需求。Nutanix容灾支持双向、一对多、多对一各种不同的复制模式。并且可以通过Nutanix自带的管理界面激活容灾中心的虚拟机进行容灾演练。不再需要额外繁琐的灾难恢复计划,基于鼠标点击即可完成容灾切换。

使用Nutanix解决方案可以在项目初始即确定今后的容灾规划,而无需在今后专门立项重复设计整体容灾架构。依据用户规模和分支机构数量,通过简单灵活的软件配置,将已有分支机构的虚拟化环境远程容灾到总部数据中心,逐步形成星型的容灾架构。